继大语言模型价格以厘计算之后,视觉理解模型也宣告进入“厘时代”。

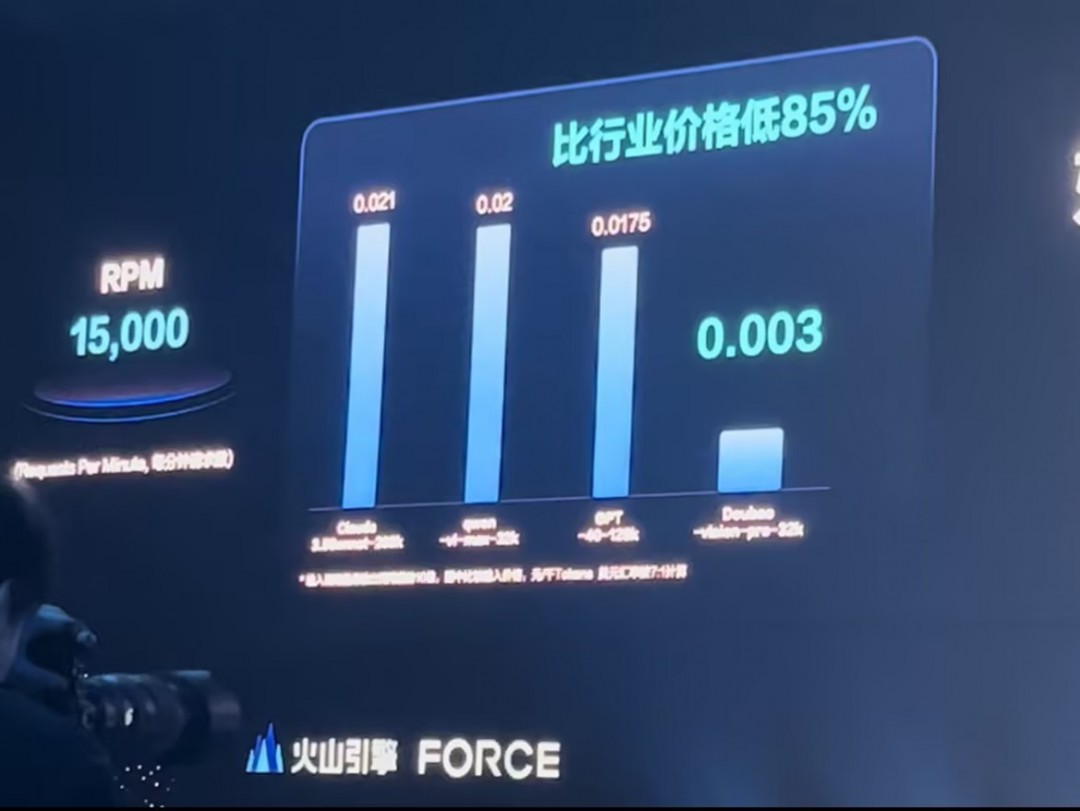

在12月18日举办的火山引擎Force大会上,字节跳动正式发布豆包视觉理解模型,该模型可为用户提供极具性价比的多模态大模型能力。豆包视觉理解模型千tokens输入价格仅为3厘,一元钱就可处理284张720P的图片,比行业价格便宜85%,以更低成本推动AI技术普惠和应用发展。

研究显示,人类接受的信息超过80%来自视觉。视觉理解将极大地拓展大模型的能力边界,同时也会降低人们与大模型交互的门槛,为大模型解锁更丰富的应用场景。

据火山引擎总裁谭待介绍,豆包视觉理解模型不仅能精准识别视觉内容,还具备出色的理解和推理能力,可根据图像信息进行复杂的逻辑计算,完成分析图表、处理代码、解答学科问题等任务。此外,该模型有着细腻的视觉描述和创作能力。

此前,豆包视觉理解模型已经接入豆包App和PC端产品。豆包战略研究负责人周昊表示:“豆包一直在努力,让用户的输入更快更方便”。为此,豆包产品非常注重多模态的输入和打磨,包括语音、视觉等能力,这些模型都已通过火山引擎开放给企业客户。

大会上,豆包3D生成模型也首次亮相。该模型与火山引擎数字孪生平台veOmniverse结合使用,可以高效完成智能训练、数据合成和数字资产制作,成为一套支持AIGC创作的物理世界仿真模拟器。

豆包大模型多款产品也迎来重要更新:豆包通用模型pro已全面对齐GPT-4o,使用价格仅为后者的1/8;音乐模型从生成60秒的简单结构,升级到生成3分钟的完整作品;文生图模型2.1版本,更是在业界首次实现精准生成汉字和一句话P图的产品化能力,该模型已接入即梦AI和豆包App。

会上,字节跳动宣告,2025年春季将推出具备更长视频生成能力的豆包视频生成模型1.5版,豆包端到端实时语音模型也将很快上线,从而解锁多角色演绎、方言转换等新能力。谭待表示,豆包大模型虽然发布较晚,但一直在快速迭代进化,目前已成为国内最全面、技术最领先的大模型之一。